방송 콘텐츠 한-중, 한-일 번역 병렬 말뭉치 데이터

- 분야한국어

- 유형 텍스트

-

데이터 변경이력

데이터 변경이력 버전 일자 변경내용 비고 1.0 2022-07-29 데이터 최초 개방 데이터 히스토리

데이터 히스토리 일자 변경내용 비고 2022-12-08 메타데이터 정보 수정 2022-07-29 콘텐츠 최초 등록 소개

• 신경망 기반 기계 번역기 학습 데이터로 활용하기 위한 한중, 한일 말뭉치 • 방송 콘텐츠 분야 번역기의 성능 향상을 위한 학습용 데이터

구축목적

• 주요 언어의 방송 콘텐츠를 효과적으로 현지화 할 수 있는 인공 신경망 기계 번역기 학습용 말뭉치 데이터 구축

-

메타데이터 구조표 데이터 영역 한국어 데이터 유형 텍스트 데이터 형식 txt 데이터 출처 방송 콘텐츠(SBS 등) 라벨링 유형 번역(자연어) 라벨링 형식 JSON 데이터 활용 서비스 신경망 기계 번역기 데이터 구축년도/

데이터 구축량2021년/300만 문장 -

1. 데이터 구축 규모

1. 데이터 구축 규모 항목명 지표 규모 구축량 문장수 • 한-중 75만

• 한-일 75만

• 중-한 45만

• 일-한 45만주제 분포 비율 13개 세부 분야별 데이터 분포 확인 문장 길이 분포 수량 (어절 수) • 한국어: 평균 15어절 (최소 2어절~최대 30어절)

• 중국어: 평균 15글자수 (최소 2글자 ~ 최대 30글자)2. 데이터 분포

2. 데이터 분포 언어 대분야 세부 분야 데이터 구축 목표 수량 한-중 TV 방송 교양 200,000 관찰예능 250,000 리얼버라이어티 예능 300,000 소계 750,000 한-일 TV 방송 교양 200,000 관찰예능 350,000 리얼버라이어티 예능 200,000 소계 750,000 중-한 TV 방송 드라마_

판타지/로맨스260,000 드라마_

범죄/서스팬스/액션90,000 드라마_

도시/가족/어드벤처100,000 소계 450,000 일-한 라디오 방송 일상 180,000 문화 180,000 경제 20,000 사회 70,000 소계 450,000 합계 2,400,000 -

AI 모델 상세 설명서 다운로드

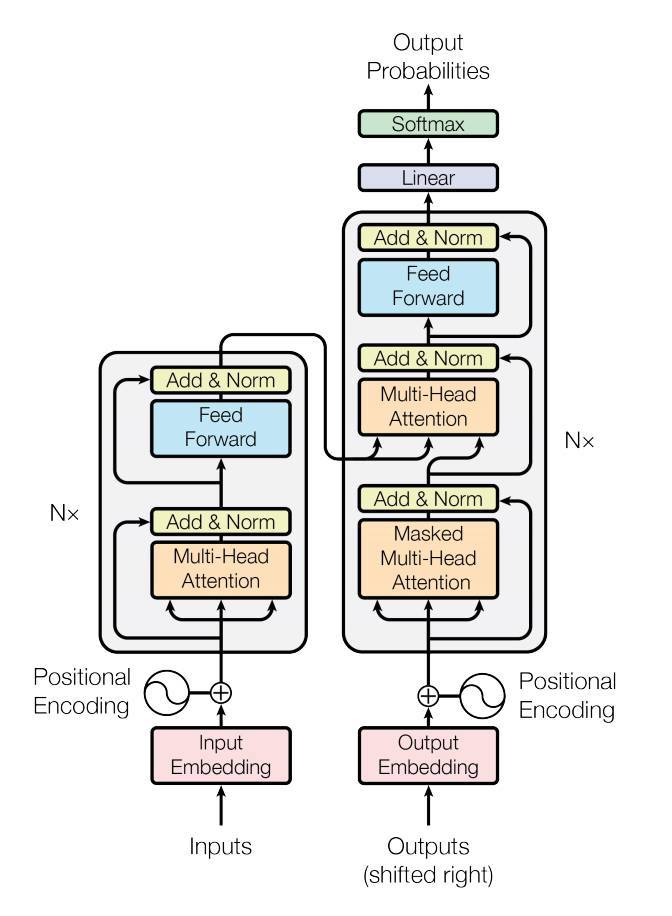

AI 모델 상세 설명서 다운로드 AI 모델 다운로드1. Attention 기반 Transformer 기계 번역기 모델

- Transformer 기계 번역기를 현재로 상용에서 사용하고 있는 기계 번역기 모델임

- Transformer의 경우 우수한 결과물을 만들기 위해서는 필수적으로 우수한 학습 데이터가 필요함

- 언어별 본 과제 분야에 특화된 번역기 모델을 학습하여 해당 분야의 수요 기관에서 직접적으로 사용이 가능함

2. 유효성 검증 모델의 학습 및 검증 조건

2. 유효성 검증 모델의 학습 및 검증 조건 유효성 검증 모델 학습 및 검증 조건 개발 언어 Python 3.7 프레임워크 PyTorch 1.8.1 학습 알고리즘 Transformer 학습 조건 – Number of epochs: 50

– Batch size: 64 / 128

– Learning rate: 0.003

– Dropout: 0.1파일 형식 학습 데이터셋: csv 평가 데이터셋: csv 전체 구축 데이터 대비 모델에 적용되는 비율 100% (1,500,000건) 모델 학습 과정별

데이터 분류 및 비율 정보– Training Set: 80% (1,920,000건)

– Validation Set:10% (240,000건)

– Test Set: 10% (240,000건) -

데이터 성능 점수

측정값 (%)기준값 (%)데이터 성능 지표

데이터 성능 지표 번호 측정항목 AI TASK 학습모델 지표명 기준값 점수 측정값 점수 1 기계번역 정확도(한-중) Machine Translation openNMT BLEU 0.7 점 0.7485 점 2 기계번역 정확도(한-일) Machine Translation openNMT BLEU 0.7 점 0.738 점 3 기계번역 정확도(중-한) Machine Translation openNMT BLEU 0.7 점 0.7084 점 4 기계번역 정확도(일-한) Machine Translation openNMT BLEU 0.7 점 0.7121 점

※ 데이터 성능 지표가 여러 개일 경우 각 항목을 클릭하면 해당 지표의 값이 그래프에 표기됩니다.

※ AI모델 평가 지표에 따라 측정값의 범위, 판단 기준이 달라질 수 있습니다. (ex. 오류율의 경우, 낮을수록 좋은 성능을 내는 것으로 평가됩니다)

-

설명서 및 활용가이드 다운로드

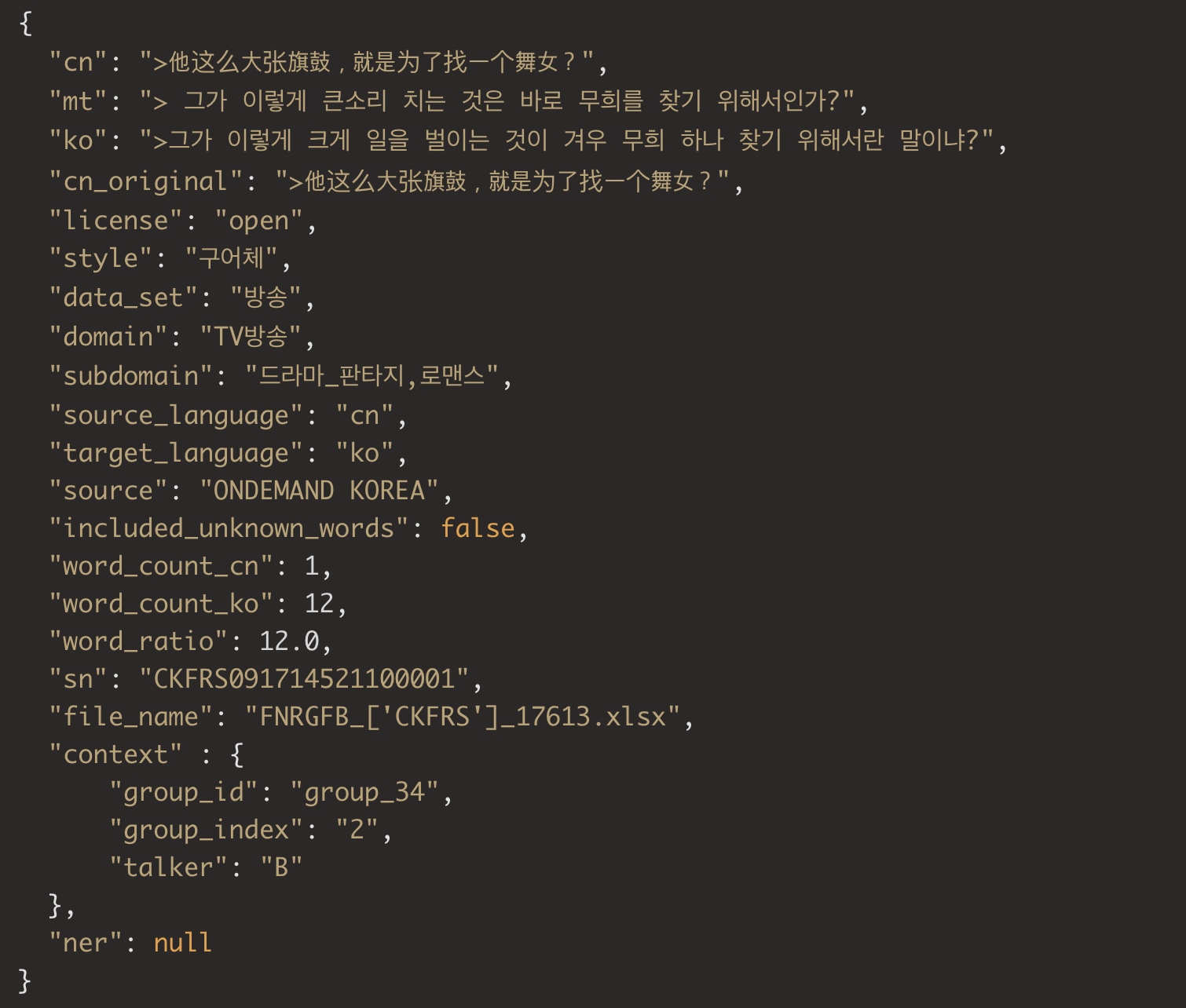

데이터 설명서 다운로드 구축활용가이드 다운로드1. 라벨링 데이터 포맷

1. 라벨링 데이터 포맷 구분 항목명 타입 필수여부 설명 1 data Object Y 데이터셋 정보 1.1 data.sn String N 시리얼 넘버 data.file_name String N 파일 이름 data.data_set String Y 데이터 분류 data.domain String Y 대분야 data.subdomain String N 하위 분야 data.source String Y 출처 data.[출발언어] String Y 개인정보 비식별화 처리된 원문 문장

(예: ko, en)data.[출발언어]_cleaned String N 띄어쓰기, 오탈자, 문장 구조를 보정한 원문 문장 (개인정보가 포함된 문장은 제외) data.[출발언어]_original String Y 1차적으로 정제된 원문 문장 data.mt String N 기계 번역문 data.[도착언어] String Y 번역문 (영문) data.source_language String Y 원문 언어 코드 data.target_language String Y 번역문 언어 코드 data.license String Y 원문의 라이선스, 명시적 라이선스 또는 상용 사용 여부 명시 data.word_count_[출발언어] Number Y 원문 어절수 data.word_count_[도착언어] Number Y 번역문 어절수 data.word_ratio Float Y 원문, 영어 어절 비율 data.included_unknown _words Boolean Y 전문용어 포함 여부 data.included_unknown_words Boolean Y 신조어, 약어, 은어 포함 여부 data.style String Y 문어체와 구어체 구분하여 원문의 문체 명시 1.2 data.context Object N 문맥을 파악할 수 있는 문장들의 정보 1.2.1 context.group_id String Y 동일한 문맥(그룹)의 식별 정보 context.group_index Number Y 동일한 문맥에서의 순차 정보 context.talker String N 구어체의 경우 화자 정보 1.3 data.ner Object N 문장 내 개체명 정보 1.3.1 ner.text String Y 원문 중 NER 태깅을 한 문장 ner.tags Array Y NER 태그 정보 1.3.1.1 tags.tag String Y NER 태그들의 상세 정보 tags.value String Y 태깅된 단어 tags.position Array Y 태깅된 단어의 원문 내의 위치 정보

[start_pos, end_pos]2. 라벨링 데이터 예시

-

데이터셋 구축 담당자

수행기관(주관) : ㈜ 트위그팜

수행기관(주관) 책임자명 전화번호 대표이메일 담당업무 최규동 1833-5926 ken.choi@twigfarm.net · 데이터 구축 수행기관(참여)

수행기관(참여) 기관명 담당업무 에퀴코리아 · 데이터 수집, 정제, 가공, 검수 한국외국어대학교 · 데이터 수집, 정제, 가공, 검수 중앙대학교 · 데이터 수집, 정제, 가공, 검수 푸르모디티 · 데이터 수집, 정제, 가공, 검수 악티보 · 사업 관리 데이터 관련 문의처

데이터 관련 문의처 담당자명 전화번호 이메일 최규동 1833-5926 ken.choi@twigfarm.net

-

인터넷과 물리적으로 분리된 온라인·오프라인 공간으로 의료 데이터를 포함하여 보안 조치가 요구되는 데이터를 다운로드 없이 접근하고 분석 가능

* 온라인 안심존 : 보안이 보장된 온라인 네트워크를 통해 집, 연구실, 사무실 등 어디서나 접속하여 데이터에 접근하고 분석

* 오프라인 안심존 : 추가적인 보안이 필요한 데이터를 대상으로 지정된 물리적 공간에서만 접속하여 데이터에 접근하고 분석 -

- AI 허브 접속

신청자 - 안심존

사용신청신청자신청서류 제출* - 심사구축기관

- 승인구축기관

- 데이터 분석 활용신청자

- 분석모델반출신청자

- AI 허브 접속

-

1. 기관생명윤리위원회(IRB) 심의 결과 통지서 [IRB 알아보기] [공용IRB 심의신청 가이드라인]

2. 기관생명윤리위원회(IRB) 승인된 연구계획서

3. 신청자 소속 증빙 서류 (재직증명서, 재학증명서, 근로계약서 등 택1)

4. 안심존 이용 신청서 [다운로드]

5. 보안서약서 [다운로드]

※ 상기 신청서 및 첨부 서류를 완비한 후 신청을 진행하셔야 정상적으로 절차가 이루어집니다. -

신청 및 이용관련 문의는 safezone1@aihub.kr 또는 02-525-7708, 7709로 문의

데이터셋 다운로드 승인이 완료 된 후 API 다운로드 서비스를 이용하실 수 있습니다.

API 다운로드 파일은 분할 압축되어 다운로드 됩니다. 분할 압축 해제를 위해서는 분할 압축 파일들의 병합이 필요하며 리눅스 명령어 사용이 필요합니다.

리눅스 OS 계열에서 다운로드 받으시길 권장하며 윈도우에서 파일 다운로드 시 wsl(리눅스용 윈도우 하위 시스템) 설치가 필요합니다.

※ 파일 병합 리눅스 명령어

find "폴더경로" -name "파일명.zip.part*" -print0 | sort -zt'.' -k2V | xargs -0 cat > "파일명.zip"

- 해당 명령어 실행 시, 실행 경로 위치에 병합 압축 파일이 생성됩니다.

- 병합된 파일 용량이 0일 경우, 제대로 병합이 되지 않은 상태이니 "폴더경로"가 제대로 입력되었는지 확인 부탁드립니다.

※ 데이터셋 소개 페이지에서 다운로드 버튼 클릭하여 승인이 필요합니다.