-

데이터 변경이력

데이터 변경이력 버전 일자 변경내용 비고 1.1 2022-10-13 루브릭 자료 개방 1.0 2022-07-28 데이터 최초 개방 데이터 히스토리

데이터 히스토리 일자 변경내용 비고 2023-04-11 담당자명 변경 2022-07-28 콘텐츠 최초 등록 소개

다양한 학년군의 에세이 및 에세이 평가 점수로 구성된 데이터 • 에세이는 전문가의 자문을 통해 구성된 50가지 주제로 구성되어 있음 • 에세이에 대한 평가는 3인의 전문가 평가를 통해 이뤄졌으며, 최대 11가지 평가항목으로 이뤄진 루브릭을 통해 데이터의 신뢰성을 높임

구축목적

초중고교생 에세이에 대한 AI 자동평가 및 다양한 교육 서비스 활용 • 에세이 글 데이터 구축을 통해 인간이 평가하는 수준의 에세이 자동 평가 모델 구축 • 인공지능 에세이 자동 평가 서비스 개발을 위한 초중고교생의 에세이 글 데이터 및 EduTech 분야 등에 다양하게 활용

-

메타데이터 구조표 데이터 영역 한국어 데이터 유형 텍스트 데이터 형식 txt, hwp 데이터 출처 초중고교 학생들 대상 수집 라벨링 유형 에세이 및 에세이 평가(자연어) 라벨링 형식 JSON 데이터 활용 서비스 에세이 자동 평가 서비스 데이터 구축년도/

데이터 구축량2021년/50,413건 -

1. 데이터 구축 규모

- 데이터 종류에 따른 데이터 수량

1. 데이터 구축 규모 데이터 종류 개수 원시 데이터 60,000건 이상 원천 데이터 50,000건 이상 라벨 데이터 50,000건 이상 라벨 데이터

(50,000건 이상)채점 라벨 포함 50,000건 이상 교정 라벨 포함 10,000건 - 손실/오류가 있는 데이터를 제외한 고품질의 라벨 데이터 50,000건 수집

- 라벨 데이터에는 채점 라벨이 모두 포함되어 있음

- 라벨 데이터 가운데 10,000건에 교정 라벨이 포함되어 있음

2. 데이터 분포

- 데이터 종류(학년군)에 따른 데이터 수량

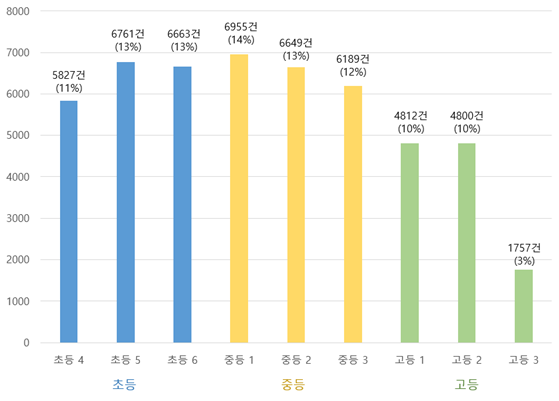

학교 학년 개수 학교 학년 개수 학교 학년 개수 초등

(38%)4학년 5,827건 중등

(39%)1학년 6,955건 고등

(23%)1학년 4,812건 5학년 6,761건 2학년 6,649건 2학년 4,800건 6학년 6,663건 3학년 6,189건 3학년 1,757건 - 획득하는 데이터가 일부 범주에만 치우치지 않고 가능한 다양한 주제와 인적/환경적 특성 고려할 수 있도록 다음과 같은 비율로 데이터를 획득

- 학년별, 학력 수준별, 성별을 고려한 모집군으로 데이터 수집

학년 Type 세부Type 주제 및

Prompt난이도 건수 4 논술,

수필논술형(51.5%)

· 주장

· 찬성/반대

· 대안 제시

수필형(48.5%)

· 설명글

· 글짓기6

Prompt의 경우

상, 중, 하 난이도로 구분

고학년 일수록 중, 상의 비율이 높아짐5,827 5 6 6,761 6 6 6,663 1 6 6,955 2 6 6,649 3 6 6,189 1 6 4,812 2 6 4,800 3 2 1,757 - - - 50 - 50,413

2. 학습 결과 및 통계

(가) 알고리즘 학습방법(AI 모델 상세 설명서 참조)

- 권장 준비 사항

• 본 과제에서 제안된 모델을 학습하기 위해서는 에세이 글 데이터셋과 공개된 모델 코드의 다운로드 및 도커를 활용한 이미지 생성 및 이미지 기반 컨테이너에서의 코드 실행이 필요

• 코드 설치과정은 도커(docker)를 활용하여 이미지를 생성하는 식으로 진행하는 것을 권장하나, conda 등의 환경을 통해 버전에 맞는 환경을 구축하여 진행하는 것 또한 가능

- 도커 환경 준비

• 본 과제에서 제안된 모델을 학습하기 위해서는 에세이 글 데이터셋과 공개된 모델 코드의 다운로드 및 도커를 활용한 이미지 생성 및 이미지 기반 컨테이너에서의 코드 실행이 필요

• 기본 설치 환경 : Linux-Ubuntu 18.04, gpu 환경(나) 학습 파라미터

파라미터명 값 epoch 50 embedding_size 768 train_steps 630 train_batch_size 64 max_seq_length 128 max_sentence_length 50 <학습 파라미터>

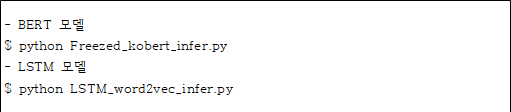

(다) 학습 결과 및 통계

- BERT 모델

$ python Freezed_kobert_infer.py

- LSTM 모델

$ python LSTM_word2vec_infer.py

- data 디렉토리 내 학습된 모델 kobert_model.h5와 lstm_model.h5 를 사용하여 전체 데이터에 대한 10%의 테스트 데이터에 대해 결과 도출

<결과 도출 명령어>

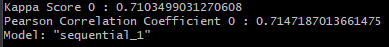

- 본 과제에서 제안한 에세이 글 데이터셋으로 BERT 기반 모델을 통해 학습한 결과 테스트 데이터에 대해 다음과 같은 성능 결과를 획득

<성능 결과 캡쳐화면>

성능 평가 지표 수치 Kappa Score 0.71 Pearson Correlation Coefficient 0.71 <성능 결과>

- 데이터 종류에 따른 데이터 수량

-

-

AI 모델 상세 설명서 다운로드

AI 모델 상세 설명서 다운로드 AI 모델 다운로드1. 모델 구축 내용

- 본 과제에서는 에세이 글을 학습하여 예상 점수를 예측하는 두 종류의 네트워크를 구축

- 하나의 네트워크는 모델 구성이 가벼우면서도 연속된 데이터에 대한 학습에 우수하다고 인정받는 LSTM Cell을 기반으로 구성

- 다른 네트워크는 모델 복잡도가 높지만 자연어 처리 분야에 있어 뛰어난 성능을 인정받는 BERT를 기반으로 한국어라는 특성, 에세이가 문장의 연속이라는 특성을 고려하여 구성

- 타 데이터셋 대비 양적 우위를 충분히 반영할 수 있도록 에세이 타입, 주제를 학습에 반영하는 방식으로 모델을 구축

- 두 네트워크에 대해 각각 학습할 수 있는 코드를 AIHub에 업로드함

- 업로드 된 코드를 사용하여 에세이 글 데이터셋을 학습할 수 있으며, 학습된 모델을 h5 파일 형태로 제공

- 생성된 모델파일을 사용해 일부 데이터셋에 대해 테스트를 할 수 있는 코드 제공

- 모델 학습이 용이하도록 도커 이미지 파일 포함

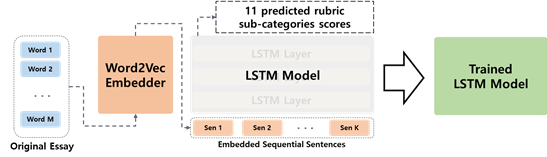

2. LSTM 기반 모델 소개 및 학습 구조 설명

- LSTM 기반 모델은 아래 구조도와 같은 방식으로 학습

[LSTM 기반 모델 소개의 학습 구조] - 에세이 글 데이터셋을 사용하여 에세이 글의 점수를 예측하는 모델을 학습하기 위해서는 모델이 이해할 수 있도록 자연어를 벡터로 임베딩(embedding)하는 처리과정이 필요

- Word2Vec 기법은 가장 기본적이면서도 준수한 성능이 나오는 임베딩 방식으로, 이를 이용하여 에세이 글 데이터셋에 대해 문장 별로 임베딩을 진행

- 임베딩된 연속된 문장을 이용하여 LSTM model이 11가지의 소분류별 평가지표에 대한 점수를 예측하도록 학습

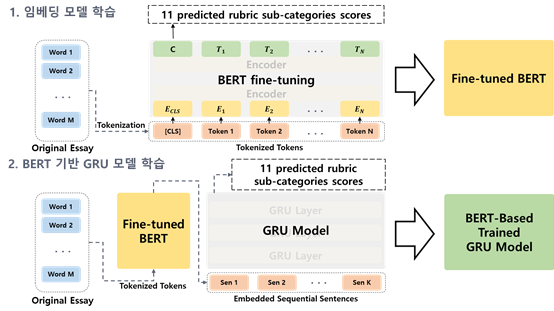

3. BERT 기반 모델 소개 및 학습 구조 설명

- BERT 기반 모델은 아래 구조도와 같은 방식으로 학습

[BERT 기반 모델의 학습 구조] - 에세이 글 데이터셋을 사용하여 에세이 글의 점수를 예측하는 모델을 학습하기 위해서는 모델이 이해할 수 있도록 자연어를 벡터로 임베딩(embedding)하는 처리과정이 필요

- 가장 먼저 한국어의 특성을 고려하여 에세이 글에 대한 토큰화 작업을 진행

- 임베딩 모델의 경우, 토큰화된 에세이를 한국어의 특성에 맞게 임베딩하기 위하여 한국어 성능 한계를 극복하기 위해 토큰화 기법 및 말뭉치 데이터를 변경을 통해 학습한 KoBERT 모델을 베이스로 선정

- 선정한 KoBERT 모델이 에세이라는 특성을 반영할 수 있도록 에세이 데이터셋을 기반으로 finetuning 기법을 사용하여 임베딩 모델을 학습

- 점수를 예측하는 모델의 경우, 에세이의 특성상 흐름을 가지고 있고 이를 연속형 데이터라는 관점으로 보았을 때, 이에 대해 성능이 뛰어나다고 알려진 GRU cell을 기반으로 모델을 구성

- 다시 Fine-tuned된 BERT를 이용하여 문장 별로 임베딩을 진행한 후, 이를 이용하여 GRU model이 11가지의 소분류별 평가지표에 대한 점수를 예측하도록 학습하는 방식으로 BERT 기반의 점수 예측 모델을 학습

-

데이터 성능 점수

측정값 (%)기준값 (%)데이터 성능 지표

데이터 성능 지표 번호 측정항목 AI TASK 학습모델 지표명 기준값 점수 측정값 점수 1 에세이 평가 정확도 Text Classification LSTM(word2vec) PCC 70 % 80.96 % 2 에세이 평가 정확도 Text Classification KoBERT PCC 70 % 82.28 % 3 에세이 평가 정확도 Text Classification LSTM(word2vec) QWK 70 % 77.76 % 4 에세이 평가 정확도 Text Classification KoBERT QWK 70 % 81.16 %

※ 데이터 성능 지표가 여러 개일 경우 각 항목을 클릭하면 해당 지표의 값이 그래프에 표기됩니다.

※ AI모델 평가 지표에 따라 측정값의 범위, 판단 기준이 달라질 수 있습니다. (ex. 오류율의 경우, 낮을수록 좋은 성능을 내는 것으로 평가됩니다)

-

설명서 및 활용가이드 다운로드

데이터 설명서 다운로드 구축활용가이드 다운로드요약

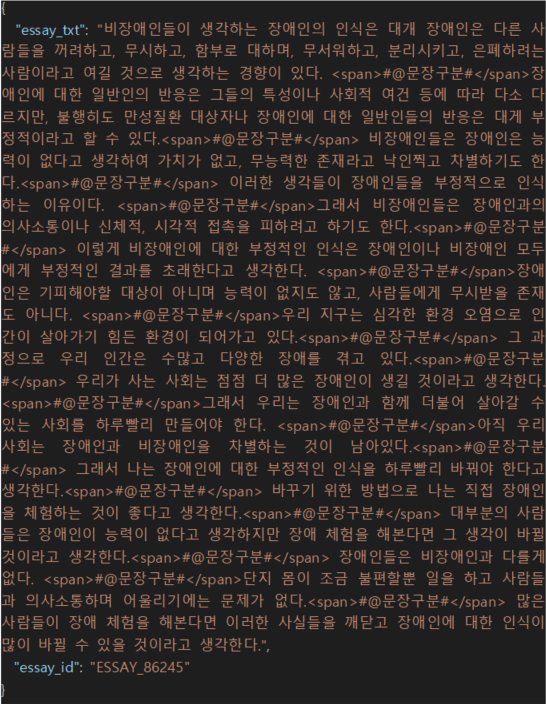

- 에세이 글 데이터는 크게 원천 데이터와 라벨링 데이터로 나뉜다.

- 각 데이터의 구분 및 항목명, 항목 타입, 항목의 필수 여부, 항목에 대한 설명 그리고 항목별 데이터 범위를 표로 제시하였다.

1. 원천 데이터

- 데이터 구성 및 어노테이션 포맷

요약 구분 항목명 타입 필수여부 설명 범위 1 essay_id string Y 에세이 아이디 2 essay_txt string Y 에세이 텍스트 1-99999 - 실제 JSON 데이터 예시

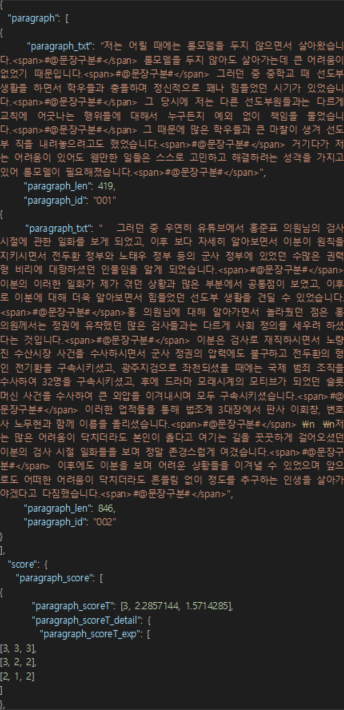

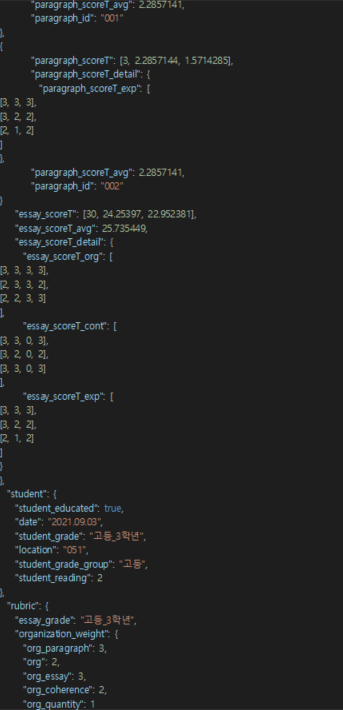

2. 라벨링 데이터

- 데이터 구성 및 어노테이션 포맷

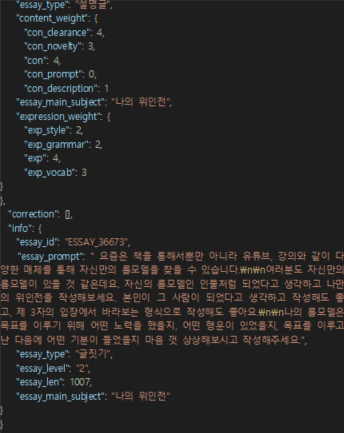

구분 항목명 타입 필수여부 설명 범위 1 info object Y 에세이 기본 정보 1.1 essay_id string Y 에세이 아이디 1.2 essay_type string Y 에세이 유형 별첨 참고 1.3 essay_main_subject string Y 에세이 주제 별첨 참고 1.4 essay_level string Y 에세이 난이도 별첨 참고 1.5 essay_prompt string Y 에세이 프롬프트 별첨 참고 1.6 essay_len number Y 에세이 글자수 1-1500 2 student object Y 에세이 작성자 정보 2.1 student_grade_group string Y 학생 학년군 별첨 참고 2.2 student_grade string Y 학생 학년 별첨 참고 2.3 student_reading number Y 학생이 일주일 간 읽은 책의 양 별첨 참고 2.4 student_educated boolean Y 학생의 논술 사교육 유무 별첨 참고 2.5 student_school string Y 학생의 소속 학교 1-99999 2.6 date string Y 에세이 수집일 2.7 location string Y 에세이 수집 장소 별첨 참고 3 paragraph array Y 에세이 문단별 정보 목록 3.1 paragraph_id string Y 문단 아이디 3.2 paragraph_len number Y 문단 글자수 1-99999 3.3 paragraph_txt string Y 문단 텍스트 1-99999 4 score object Y 에세이 점수 정보 4.1 essay_scoreT array Y 3명의 평가자 에세이 총점 목록 3-3 4.2 essay_scoreT_avg number Y 3명의 평가자 에세이 총점 평균 0-30 4.3 essay_scoreT_detail object Y 항목별 세부 정보 4.3.1 essay_scoreT_exp array Y 3명의 평가자별 전체 표현 점수 목록 0-3 4.3.2 essay_scoreT_org array Y 3명의 평가자별 전체 구성 점수 목록 0-3 4.3.3 essay_scoreT_cont array Y 3명의 평가자별 전체 내용 점수 목록 0-3 4.4 paragraph_score array Y 문단별 점수 정보 1-99999 4.4.1 paragraph_id string Y 문단 아이디 4.4.1 paragraph_scoreT array Y 3명의 평가자 문단 총점 목록 3-3 4.4.2 paragraph_scoreT_avg number Y 3명의 평가자 문단 총점 평균 0-3 4.4.3 paragraph_scoreT_detail object Y 문단 항목별 세부 정보 4.4.3.1 paragraph_scoreT_exp array Y 3명의 평가자별 문단 표현 점수 목록 0-3 5 correction array 에세이 교정 정보 0-99999 5.1 sentence_id string 문장 아이디 5.2 sentence_txt string 원 텍스트 0-99999 5.3 sentence_corr_txt_grammar string 문법 교정된 텍스트 0-99999 5.4 sentence_corr_txt_styling string 스타일링 교정된 텍스트 0-99999 5.5 sentence_corr_type array 교정 유형 목록 별첨 참고 5.6 sentence_corr_detail_type array 교정 세부 유형 목록 별첨 참고 5.7 sentence_corr_reason array 교정 이유 코멘트 목록 0-99999 5.8 sentence_annotation_tag string 어노테이션 태그 별첨 참고 5.9 paragraph_id string 문단 식별자 6 rubric object Y 루브릭 정보 6.1 essay_type string Y 에세이 유형 별첨 참고 6.2 essay_main_subject string Y 에세이 주제 별첨 참고 6.3 essay_grade string Y 에세이 작성자 학년 별첨 참고 6.4 expression_weight object Y 루브릭 표현 가중치 정보 6.4.1 exp number Y 대분류 표현 가중치 0-10 6.4.2 exp_grammar number Y 문법 가중치 0-10 6.4.3 exp_vocab number Y 단어 가중치 0-10 6.4.4 exp_style number Y 문장표현 가중치 0-10 6.5 organization_weight object Y 루브릭 구성 가중치 정보 6.5.1 org number Y 대분류 구성 가중치 0-10 6.5.2 org_essay number Y 문단 간 가중치 0-10 6.5.3 org_paragraph number Y 문단 내 가중치 0-10 6.5.4 org_coherence number Y 일관성 가중치 0-10 6.5.5 org_quantity number Y 분량 가중치 0-10 6.6 content_weight object Y 루브릭 내용 가중치 정보 6.6.1 con number Y 대분류 내용 가중치 0-10 6.6.2 con_clearance number Y 주제 명료성 가중치 0-10 6.6.3 con_novelty number Y 참신성 가중치 0-10 6.6.4 con_prompt number Y 프롬프트 독해력 가중치 0-10 6.6.5 con_description number Y 서술력 가중치 0-10 - 실제 JSON 데이터 예시

-

데이터셋 구축 담당자

수행기관(주관) : (주)티맥스에이아이

수행기관(주관) 책임자명 전화번호 대표이메일 담당업무 김미아 031-8018-9399 mia_kim@tmax.co.kr · 에세이 글 데이터 과제 총괄 수행기관(참여)

수행기관(참여) 기관명 담당업무 주식회사 교육다움 · 데이터 수집 (주)유핏 · 데이터 수집 및 가공 주식회사 세명소프트 · 데이터 정제 (사)한국에듀테크산업협회 · 데이터 정제 (주)인터마인즈 · 데이터 품질 검수 및 검증 데이터 관련 문의처

데이터 관련 문의처 담당자명 전화번호 이메일 김정현 031-8018-9467 jeonghyun_kim8@tmax.co.kr

-

인터넷과 물리적으로 분리된 온라인·오프라인 공간으로 의료 데이터를 포함하여 보안 조치가 요구되는 데이터를 다운로드 없이 접근하고 분석 가능

* 온라인 안심존 : 보안이 보장된 온라인 네트워크를 통해 집, 연구실, 사무실 등 어디서나 접속하여 데이터에 접근하고 분석

* 오프라인 안심존 : 추가적인 보안이 필요한 데이터를 대상으로 지정된 물리적 공간에서만 접속하여 데이터에 접근하고 분석 -

- AI 허브 접속

신청자 - 안심존

사용신청신청자신청서류 제출* - 심사구축기관

- 승인구축기관

- 데이터 분석 활용신청자

- 분석모델반출신청자

- AI 허브 접속

-

1. 기관생명윤리위원회(IRB) 심의 결과 통지서 [IRB 알아보기]

2. 기관생명윤리위원회(IRB) 승인된 연구계획서

3. 신청자 소속 증빙 서류 (재직증명서, 재학증명서, 근로계약서 등 택1)

4. 안심존 이용 신청서 [다운로드]

5. 보안서약서 [다운로드]

※ 상기 신청서 및 첨부 서류를 완비한 후 신청을 진행하셔야 정상적으로 절차가 이루어집니다. -

신청 및 이용관련 문의는 safezone1@aihub.kr 또는 02-525-7708, 7709로 문의

데이터셋 다운로드 승인이 완료 된 후 API 다운로드 서비스를 이용하실 수 있습니다.

API 다운로드 파일은 분할 압축되어 다운로드 됩니다. 분할 압축 해제를 위해서는 분할 압축 파일들의 병합이 필요하며 리눅스 명령어 사용이 필요합니다.

리눅스 OS 계열에서 다운로드 받으시길 권장하며 윈도우에서 파일 다운로드 시 wsl(리눅스용 윈도우 하위 시스템) 설치가 필요합니다.

※ 파일 병합 리눅스 명령어

find "폴더경로" -name "파일명.zip.part*" -print0 | sort -zt'.' -k2V | xargs -0 cat > "파일명.zip"

- 해당 명령어 실행 시, 실행 경로 위치에 병합 압축 파일이 생성됩니다.

- 병합된 파일 용량이 0일 경우, 제대로 병합이 되지 않은 상태이니 "폴더경로"가 제대로 입력되었는지 확인 부탁드립니다.

※ 데이터셋 소개 페이지에서 다운로드 버튼 클릭하여 승인이 필요합니다.