립리딩(입모양) 음성인식 데이터

- 분야한국어

- 유형 오디오 , 비디오 , 텍스트

-

데이터 변경이력

데이터 변경이력 버전 일자 변경내용 비고 1.0 2022-07-12 데이터 최초 개방 데이터 히스토리

데이터 히스토리 일자 변경내용 비고 2022-11-14 AI 모델 상세설명 업데이트 2022-10-14 신규 샘플데이터 개방 2022-07-12 콘텐츠 최초 등록 소개

다양한 환경에서 복잡한 음성인식 기반 서비스 제공을 위해 음향 외 시각 정보를 활용하여 입모양 인식을 위한 다양한 각도 및 소음환경에서 녹화된 오디오 및 비주얼 데이터로 구성된 융합 데이터

구축목적

영상 및 음성에 대한 노이즈가 심한 환경에서 음성인식 성능을 보완할 수 있는 립리딩(입모양) 인식이 가능한 형태의 오디오 및 비주얼 데이터로 구성된 융합 데이터 구축

-

메타데이터 구조표 데이터 영역 한국어 데이터 유형 오디오 , 비디오 , 텍스트 데이터 형식 영상(mp4), 음성(wav) 데이터 출처 자체 수집 라벨링 유형 전사(음성), 바운딩박스(동영상) 라벨링 형식 json 데이터 활용 서비스 AI 아바타, 청각 장애인을 위한 발음 교정 서비스 등 데이터 구축년도/

데이터 구축량2021년/원천데이터(영상) 5,750시간, 원천데이터(음성) 1,150시간, 라벨링데이터(json) 6,620건 -

1. 데이터 구축 규모

-

1. 데이터 구축 규모 데이터 종류 데이터 형태 데이터 규모 원천데이터 – 영상 mp4 5,750 시간 원천데이터 - 음성 wav 1,150 시간 라벨링데이터 – 텍스트 json 66,420 건

2. 데이터 분포

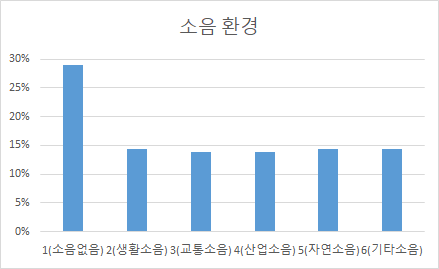

- 소음환경별 분포

* 시간 단위 이하 반올림소음환경 구축량 (시간) 비율 소음없음 1,648 29% 생활소음 828 14% 교통소음 801 14% 산업소음 804 14% 자연소음 834 14% 기타소음 833 14%

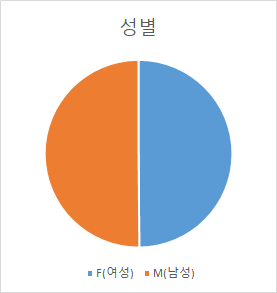

- 성별 분포

성별 인원 (명) 비율 여성 552 50% 남성 555 50%

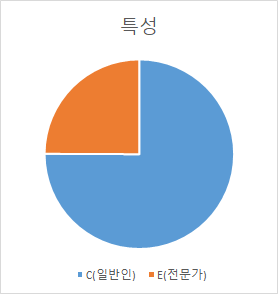

- 발화자 특성별 분포

특성 인원 (명) 비율 일반인 831 75% 전문가 276 25%

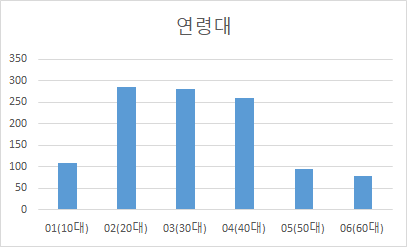

- 연령대별 분포

연령대 인원 (명) 비율 10대 109 10% 20대 286 26% 30대 280 25% 40대 259 23% 50대 94 8% 60대 79 7%

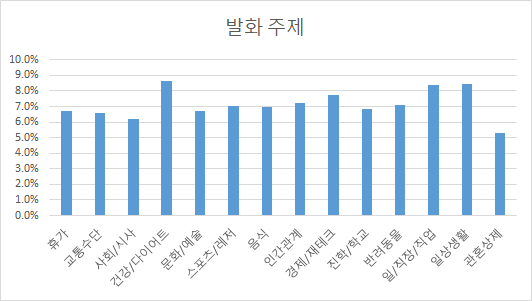

- 주제별 분포

* 시간 단위 이하 반올림발화 주제 구축량 (시간) 비율 휴가 384 6.70% 교통수단 379 6.60% 사회/시사 357 6.20% 건강/다이어트 497 8.70% 문화/예술 388 6.70% 스포츠/레저 406 7.10% 음식 399 6.90% 인간관계 413 7.20% 경제/재테크 445 7.70% 진학/학교 394 6.80% 반려동물 409 7.10% 일/직장/직업 480 8.40% 일상생활 484 8.50% 관혼상제 307 5.30%

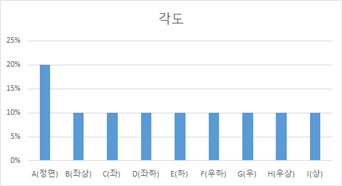

- 각도별 분포

각도 구축량 (시간) 비율 A(정면) 1,150 20% B(좌상) 576 10% C(좌) 574 10% D(좌하) 576 10% E(하) 574 10% F(우하) 576 10% G(우) 574 10% H(우상) 576 10% I(상) 574 10%

-

-

-

AI 모델 상세 설명서 다운로드

AI 모델 상세 설명서 다운로드 AI 모델 다운로드1. 모델 학습

- 학습 모델 연구

- 검증 과정에서 사용한 모델은 Transformer이고, 2017년 Google이 발표한 논문인 “Attention is all you need”에서 소개된 모델로 기존의 seq2seq의 구조인 인코더-디코더를 따르면서도, 논문의 이름처럼 어텐션(Attention)만으로 구현한 모델

- 해당 모델은 RNN을 사용하지 않고, 인코더-디코더 구조를 설계하였음에도 성능이 RNN보다 우수하다는 특징

- 학습 모델의 코드 검증을 위해 Github에 공개된 Transformer 기반의 AIHub 한국어 음성인식 코드를 기반으로 하여 Audio-Visual 학습 모델 코드를 구현

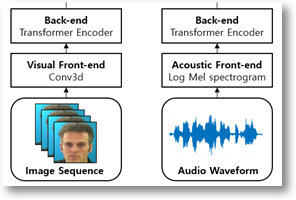

- 학습 모델 설계

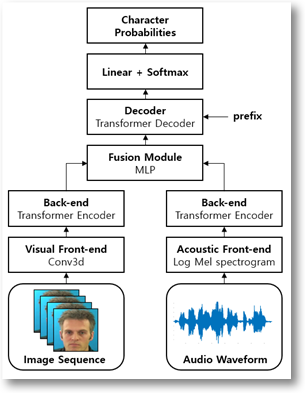

- Audio-Visual Encoder Layer

- 오디오와 비디오를 입력으로 받아 디코더가 해석하기에 용이하도록 특징 벡터열들을 추출

- 각각 비디오의 이미지 열들은 3차원 Convolution layer를 기반으로 하여 2차원의 이미지를 나타내는 1차원의 벡터로 바꿔 주고, 오디오는 Log-mel spectrogram으로 변환한 뒤, 비디오와 오디오의 특징열들을 Transformer Encoder Layer의 입력으로 하여 각 모달리티의 특징을 뽑도록 학습 진행

[그림] Audio-Visual Encoder Layer

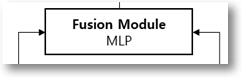

- Audio-Visual Fusion Layer

- 각 Encoder를 통해 얻어진 비디오와 오디오 특징 벡터열들을 하나의 data로 fusion하는 네트워크를 학습하는 과정

- 비디오와 오디오를 하나의 벡터열로 연결한 이후 MLP layer와 normalization, 활성함수 등을 사용하여 Decoder가 해석하기 용이하도록 특징 벡터열로 만들어주는 모델을 학습

[그림] Audio-Visual Fusion Layer

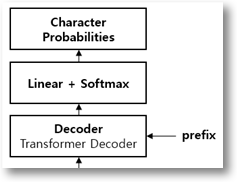

- Audio-Visual Decoder Layer

- 위 두 단계를 통해 얻은 특징 벡터열들과 Label token을 사용하여 Decoder를 통해 인식하는 네트워크를 학습

- Decoder는 Transformer Decoder Layer를 사용하여 모델을 구성

[그림] Audio-Visual Decoder Layer- 위 세 단계를 합쳐서 최종 학습 모델을 구성하며, 최종 학습 모델은 하나의 pair로 이루어진 비디오와 오디오 데이터를 입력으로 받아 해당 데이터가 어떠한 발화인지 인식

[그림] 전체 학습 모델 블록도

- Audio-Visual Encoder Layer

- 모델 학습 세팅

- Cross-Entropy loss, Adam optimizer 등을 사용하여 모델을 학습하는 데 구성

- 잡음 환경과 오디오의 발화 길이가 다양한 분포를 갖고 있기 때문에, 모델 학습을 용이하게 하기 위해 Curriculum learning 방식을 시도

- Curriculum learning을 통해 짧은 길이의 데이터부터 긴 길이의 데이터를 학습하고, 잡음이 없는 환경의 데이터부터 잡음이 존재하는 데이터를 학습하는 방향으로 진행

- 이를 통해 학습이 용이한 데이터부터 점차 일반적인 데이터로 확장하여 모델의 학습이 빠르고 적절하게 이루어지도록 함

- 음성인식 성능 평가를 진행하기 위해 음절오류율(CER)과 단어오류율(WER)을 통해 평가 진행

- 전문가 데이터의 10% 만큼의 수량을 가지고 모델을 테스트했을 때 CER 25%와 WER 50%의 인식 성능을 내도록 하는 것이 목표 성능이고, 이 결과를 통해 학습 모델을 가지고 데이터의 유효성을 판단할 수 있는 근거로 제시

2. 서비스 활용 시나리오

- 구축한 모델은 AI 아바타, 청각장애인 인식용 서비스 개발 등에 활용할 수 있음

- AI 아바타 : 해당 과제를 통해 구축한 립리딩 데이터셋을 활용하여 AI 아바타 모델을 학습할 수 있음. 이를 통해 보다 자연스러운 아바타의 립리딩(입모양) 발화가 가능함.

[출처 : maum.ai 홈페이지] - 청각 장애인을 위한 발음 교정 서비스 : 최근 청각장애인들을 위한 발음 교정용 학습 시스템들이 많이 연구되고 있으며, 발성 뿐만 아니라 입의 모양이 올바른지 확인이 필요함. 따라서 본 과제의 데이터셋을 활용하여 한국어 립리딩(입모양) 시스템 개발에 활용할 수 있음.

- 학습 모델 연구

-

설명서 및 활용가이드 다운로드

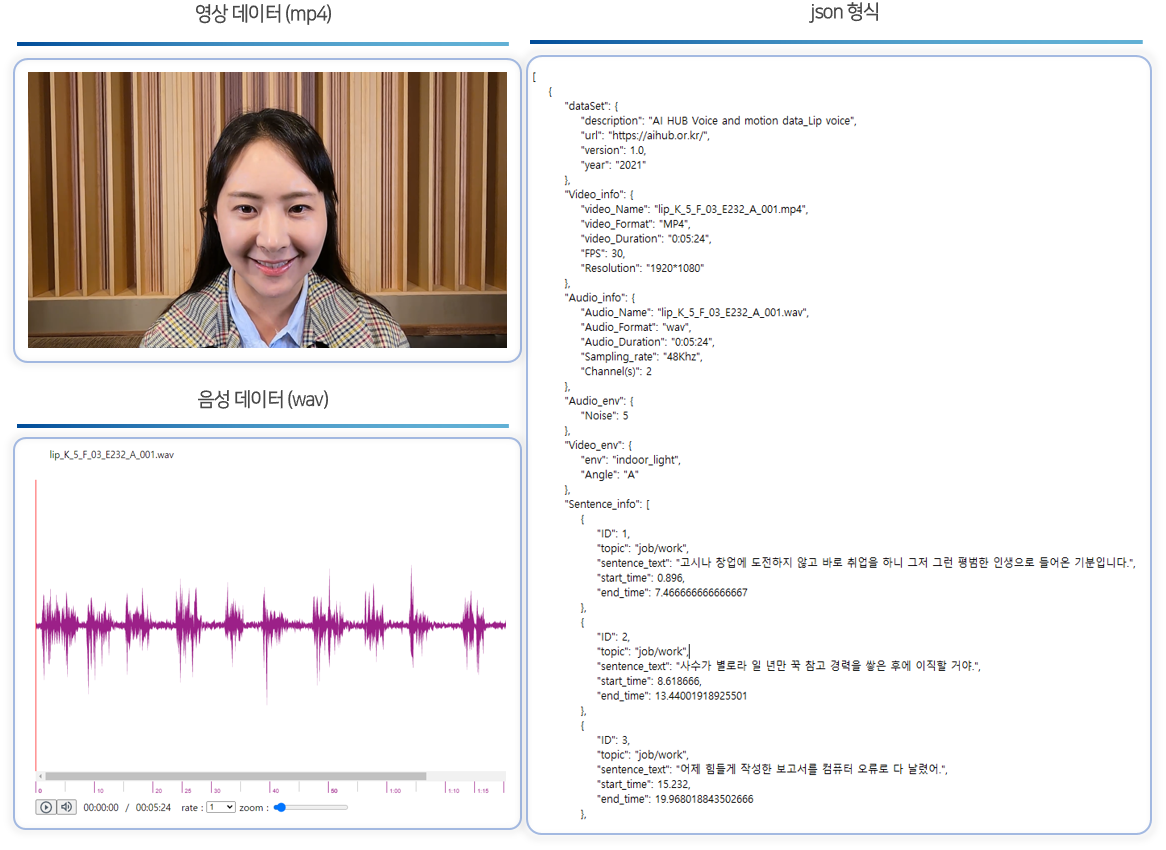

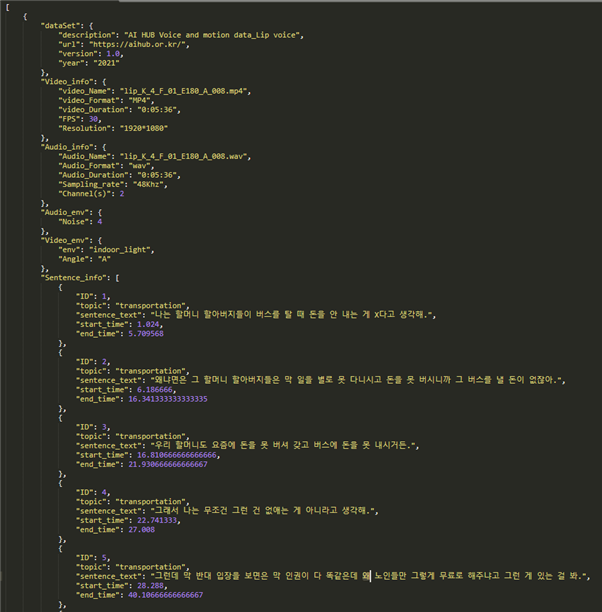

데이터 설명서 다운로드 구축활용가이드 다운로드1. 데이터셋 구성

2. 라벨링데이터 구성

1. 데이터셋 구성 번호 항목 타입 필수여부 영문명 한글명 1 dataset 데이터셋 object Y 1–1 description 데이터 정보 string Y 1–2 url 데이터셋 url (AIHUB 홈페이지) string Y 1–3 version 데이터 버전 number Y 1–4 year 연도 string Y 2 video_info 영상 정보 object Y 2–1 video_name 영상 파일명 string Y 2–2 video_format 영상 포맷 string Y 2–3 video_duration 영상 길이 string Y 2–4 FPS 프레임 number Y 2–5 resolution 해상도 string Y 3 audio_info 음성 정보 object Y 3–1 audio_name 음성 파일명 string Y 3–2 audio_format 음성 포맷 string Y 3–3 audio_duration 음성 길이 string Y 3–4 sampling_rate 오디오 샘플링레이트 string Y 3–5 channel(s) 오디오 채널 수 number Y 4 audio_env 음성 환경 object Y 4–1 noise 소음환경 number Y 5 video_env 영상 환경 object Y 5–1 env 촬영환경 string 5–2 angle 촬영각도 string Y 6 sentence_info 문장정보 array Y 6–1 id 문장 ID string Y 6–2 topic 발화주제 string Y 6–3 sentence_text 발화내용 string Y 6–4 start_time 발화 시작 시간 number Y 6–5 end_time 발화 종료 시간 number Y 7 speaker_info 발화자 정보 object Y 7–1 speaker_ID 발화자 ID string Y 7–2 specificity 특성 string Y 7–3 gender 성별 string Y 7–4 age 연령대 number Y 7–5 accent 사투리 string Y 8 bounding_box_info 바운딩박스 정보 object Y 8–1 Face_bounding_box 얼굴 영역 바운딩박스 array Y 8–1–1 xtl_ytl_xbr_ybr 얼굴 영역 좌표값 number Y 8–2 Lip_bounding_box 입술 영역 바운딩박스 array Y 8–2–1 xtl_ytl_xbr_ybr 입술 영역 좌표값 number Y 3. 라벨링데이터 실제 예시

-

데이터셋 구축 담당자

수행기관(주관) : ㈜마인즈랩

수행기관(주관) 책임자명 전화번호 대표이메일 담당업무 송혜원 031-625-4349 pworks@mindslab.ai · 데이터 품질관리 수행기관(참여)

수행기관(참여) 기관명 담당업무 ㈜크라우드웍스 · 데이터 수집, 정제, 가공 서강대학교 산학협력단 · 학습 모델 개발 데이터 관련 문의처

데이터 관련 문의처 담당자명 전화번호 이메일 송혜원 031-625-4349 pworks@mindslab.ai

-

인터넷과 물리적으로 분리된 온라인·오프라인 공간으로 의료 데이터를 포함하여 보안 조치가 요구되는 데이터를 다운로드 없이 접근하고 분석 가능

* 온라인 안심존 : 보안이 보장된 온라인 네트워크를 통해 집, 연구실, 사무실 등 어디서나 접속하여 데이터에 접근하고 분석

* 오프라인 안심존 : 추가적인 보안이 필요한 데이터를 대상으로 지정된 물리적 공간에서만 접속하여 데이터에 접근하고 분석 -

- AI 허브 접속

신청자 - 안심존

사용신청신청자신청서류 제출* - 심사구축기관

- 승인구축기관

- 데이터 분석 활용신청자

- 분석모델반출신청자

- AI 허브 접속

-

1. 기관생명윤리위원회(IRB) 심의 결과 통지서 [IRB 알아보기]

2. 기관생명윤리위원회(IRB) 승인된 연구계획서

3. 신청자 소속 증빙 서류 (재직증명서, 재학증명서, 근로계약서 등 택1)

4. 안심존 이용 신청서 [다운로드]

5. 보안서약서 [다운로드]

※ 상기 신청서 및 첨부 서류를 완비한 후 신청을 진행하셔야 정상적으로 절차가 이루어집니다. -

신청 및 이용관련 문의는 safezone1@aihub.kr 또는 02-525-7708, 7709로 문의

데이터셋 다운로드 승인이 완료 된 후 API 다운로드 서비스를 이용하실 수 있습니다.

API 다운로드 파일은 분할 압축되어 다운로드 됩니다. 분할 압축 해제를 위해서는 분할 압축 파일들의 병합이 필요하며 리눅스 명령어 사용이 필요합니다.

리눅스 OS 계열에서 다운로드 받으시길 권장하며 윈도우에서 파일 다운로드 시 wsl(리눅스용 윈도우 하위 시스템) 설치가 필요합니다.

※ 파일 병합 리눅스 명령어

find "폴더경로" -name "파일명.zip.part*" -print0 | sort -zt'.' -k2V | xargs -0 cat > "파일명.zip"

- 해당 명령어 실행 시, 실행 경로 위치에 병합 압축 파일이 생성됩니다.

- 병합된 파일 용량이 0일 경우, 제대로 병합이 되지 않은 상태이니 "폴더경로"가 제대로 입력되었는지 확인 부탁드립니다.

※ 데이터셋 소개 페이지에서 다운로드 버튼 클릭하여 승인이 필요합니다.